基于 SparkCore 的天氣監測器(含代碼)

9

9

拍明

拍明

原標題:基于 SparkCore 的天氣監測器(含代碼)

一、系統概述

基于SparkCore的天氣監測器主要包括數據采集、數據預處理、數據存儲、數據分析和數據可視化等模塊。數據采集模塊負責從各種天氣傳感器中收集數據,數據預處理模塊則對采集到的數據進行清洗和格式化,以便后續分析。數據存儲模塊將數據保存在可靠的存儲介質中,如Hadoop分布式文件系統(HDFS)或數據庫。數據分析模塊利用SparkCore的強大計算能力對存儲的數據進行深入分析,提取有價值的信息。最后,數據可視化模塊將分析結果以圖表、圖像等形式直觀地展示出來。

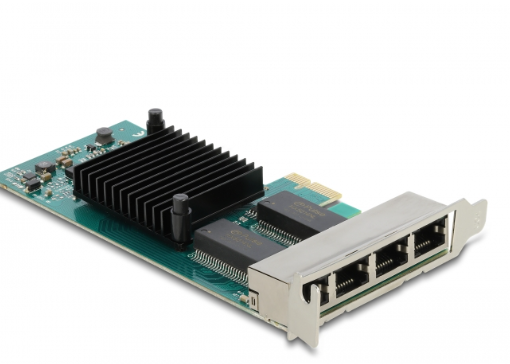

二、主控芯片型號及其作用

在設計基于SparkCore的天氣監測器時,主控芯片的選擇至關重要。主控芯片負責協調整個系統的運行,包括數據處理、存儲和通信等功能。以下是一些可能的主控芯片型號及其在設計中的作用:

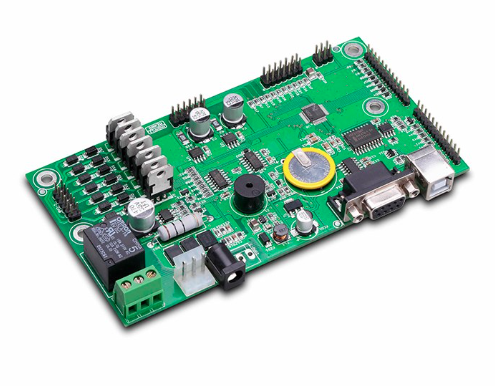

SparkCore(基于Arduino平臺)

型號:SparkCore(或兼容的Arduino板,如Arduino Uno、Arduino Mega等)

作用:作為系統的控制核心,SparkCore負責接收來自傳感器的數據,通過串口通信等方式將數據發送到Spark集群進行處理。它還負責接收來自Spark集群的分析結果,并通過各種接口(如LCD顯示屏、LED指示燈等)將結果顯示給用戶。

ARM Cortex-M系列

型號:如STM32F4系列、NXP i.MX系列等

作用:ARM Cortex-M系列芯片具有高性能、低功耗的特點,非常適合用于天氣監測器中作為數據處理和控制的核心。它們可以處理來自多個傳感器的數據,執行復雜的算法,并將處理后的數據發送到Spark集群進行進一步分析。

RISC-V系列

型號:如SiFive Freedom系列、RISC-V Development Board等

作用:RISC-V系列芯片是一種開源的指令集架構,具有高度的靈活性和可擴展性。在天氣監測器中,RISC-V芯片可以作為數據處理和控制的核心,通過定制化的指令集和硬件加速功能,提高數據處理效率和降低功耗。

ESP32系列

型號:如ESP32-WROOM-32、ESP32-S系列等

作用:ESP32系列芯片集成了Wi-Fi和藍牙功能,非常適合用于需要無線通信的天氣監測器中。它們可以輕松地連接到互聯網,將數據傳輸到遠程的Spark集群進行處理和分析。同時,ESP32還具有強大的數據處理能力,可以執行一些基本的算法和數據處理任務。

三、代碼示例

以下是一個基于SparkCore的天氣監測器的部分代碼示例,包括數據采集、數據預處理和數據分析等模塊的代碼。請注意,這只是一個簡化的示例,實際的系統可能需要更復雜的代碼和更多的模塊。

1. 數據采集模塊

數據采集模塊使用Python語言編寫,通過模擬傳感器接口來收集數據。以下是一個簡單的數據采集代碼示例:

import time import random

# 模擬傳感器接口 def read_sensor_data(): temperature = random.uniform(20.0, 30.0) # 隨機生成溫度數據 humidity = random.uniform(50.0, 80.0) # 隨機生成濕度數據 pressure = random.uniform(1000.0, 1020.0) # 隨機生成氣壓數據 return {"temperature": temperature, "humidity": humidity, "pressure": pressure}

# 采集數據并打印 while True: data = read_sensor_data() print(f"Temperature: {data['temperature']}°C, Humidity: {data['humidity']}%, Pressure: {data['pressure']}hPa") time.sleep(5) # 每5秒采集一次數據

2. 數據預處理模塊

數據預處理模塊使用Pandas庫對數據進行清洗和格式化。以下是一個簡單的數據預處理代碼示例:

import pandas as pd

# 假設這是從傳感器采集到的原始數據 raw_data = [ {"timestamp": "2023-10-01T00:00:00", "temperature": 25.1, "humidity": 60.2, "pressure": 1010.5}, {"timestamp": "2023-10-01T00:05:00", "temperature": 25.3, "humidity": 60.5, "pressure": 1010.8}, # ... 更多數據 ]

# 將原始數據轉換為DataFrame df = pd.DataFrame(raw_data)

# 將時間戳轉換為datetime類型 df['timestamp'] = pd.to_datetime(df['timestamp'])

# 設置時間戳為索引 df.set_index('timestamp', inplace=True)

# 打印預處理后的數據 print(df.head())

3. 數據分析模塊

數據分析模塊使用Spark Core進行大規模數據處理和分析。以下是一個簡單的數據分析代碼示例,使用Scala語言編寫:

import org.apache.spark.sql.SparkSession

object WeatherAnalysis { def main(args: Array[String]): Unit = { // 創建SparkSession val spark = SparkSession.builder() .appName("WeatherAnalysis") .getOrCreate()

// 讀取預處理后的數據(假設已經保存到HDFS或數據庫中) val df = spark.read.format("csv").option("header", "true").load("hdfs:///path/to/preprocessed_data.csv")

// 分析每個月的平均氣溫 val monthlyAvgTemp = df.groupBy(df.col("timestamp").cast("date").cast("string").substr(0, 7)) // 提取年月 .agg(avg("temperature").as("avg_temperature"))

// 打印分析結果 monthlyAvgTemp.show()

// 停止SparkSession spark.stop() } }

請注意,上述代碼示例中的文件路徑和數據格式可能需要根據實際情況進行調整。此外,實際的系統還需要考慮數據的實時性、數據的存儲和傳輸方式、系統的穩定性和可靠性等問題。

四、總結

基于SparkCore的天氣監測器是一個復雜的系統,需要綜合考慮數據采集、數據預處理、數據存儲、數據分析和數據可視化等多個模塊。在選擇主控芯片時,需要根據系統的具體需求和性能要求來選擇合適的芯片型號。通過合理的代碼設計和優化,可以實現高效、準確和可靠的天氣監測功能。

責任編輯:David

【免責聲明】

1、本文內容、數據、圖表等來源于網絡引用或其他公開資料,版權歸屬原作者、原發表出處。若版權所有方對本文的引用持有異議,請聯系拍明芯城(marketing@iczoom.com),本方將及時處理。

2、本文的引用僅供讀者交流學習使用,不涉及商業目的。

3、本文內容僅代表作者觀點,拍明芯城不對內容的準確性、可靠性或完整性提供明示或暗示的保證。讀者閱讀本文后做出的決定或行為,是基于自主意愿和獨立判斷做出的,請讀者明確相關結果。

4、如需轉載本方擁有版權的文章,請聯系拍明芯城(marketing@iczoom.com)注明“轉載原因”。未經允許私自轉載拍明芯城將保留追究其法律責任的權利。

拍明芯城擁有對此聲明的最終解釋權。

產品分類

產品分類

2012- 2022 拍明芯城ICZOOM.com 版權所有 客服熱線:400-693-8369 (9:00-18:00)

2012- 2022 拍明芯城ICZOOM.com 版權所有 客服熱線:400-693-8369 (9:00-18:00)